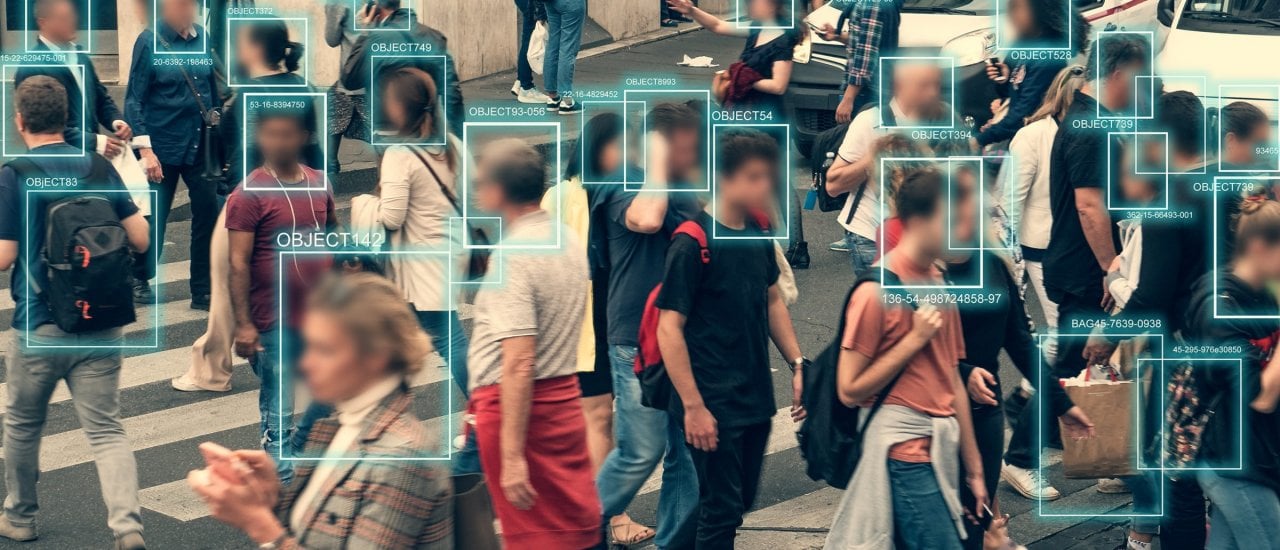

Wut, Trauer, Freude: Schon heute kann künstliche Intelligenz (KI) Emotionen erkennen. Bislang kommt das vor allem in Werbung und Marketing zum Einsatz. So wird etwa mithilfe von Kameras untersucht, wie potenzielle Kundinnen und Kunden auf bestimmte Produkte im Supermarkt oder auf Messen reagieren. Auch in Bewerbungsgesprächen setzen einige Unternehmen bereits KI ein, um mithilfe der Algorithmen mehr über die Bewerberinnen und Bewerber zu erfahren.

Forschende arbeiten daran, diese Technologien noch zu verbessern und so weitere Anwendungsgebiete zu erschließen. In Zukunft könnten beispielsweise Strafverfolgung und Sicherheitsbehörden auf KI setzen, etwa bei Lügendetektoren oder an Grenzübergängen.

Rassistische KI

Dabei gibt es allerdings ein Problem: KI ist – anders als oft vermutet – nicht neutral und objektiv. Auch wenn die Algorithmen dazulernen, basieren sie nämlich auf den Ideen von Menschen und übernehmen so deren Vorurteile. Ein Beispiel ist die Theorie der Basisemotionen des Psychologen Paul Ekman, auf der die Datensätze der Algorithmen häufig basieren. Diese Theorie ist heute allerdings umstritten, weil sie kulturelle und individuelle Unterschiede nicht berücksichtigt.

Studien zeigen beispielsweise, dass KI rassistisch urteilt: So wurden in einer Untersuchung von US-Basketballern den schwarzen Spielern häufiger negative Emotionen unterstellt als ihren weißen Kollegen. Andere Beispiele zeigen einen sexistischen Bias der Algorithmen. Zum Beispiel wurden in Bewerbungsverfahren bei Amazon Frauen häufiger aussortiert als männliche Kandidaten. In einer Studie mit US-Kongressabgeordneten bewertete ein Computerprogramm Frauen als freundlicher und sympathischer.

KI lernt anhand der Daten, die wir ihr geben. Wenn die Datensätze Vorurteile beinhalten, wird die KI diese lernen und dann auch anwenden.

Manon Bischoff

Geht man davon aus, dass KI in Zukunft noch deutlich häufiger zum Einsatz kommen wird, gilt es daher, diese Vorurteile in den Datensätzen auszumerzen oder sich zumindest darüber im Klaren zu sein, dass auch der Computer diskriminierende Urteile fällen kann. Manon Bischoff von Spektrum der Wissenschaft erklärt im Gespräch mit detektor.fm-Moderator Marc Zimmer, wie das gelingen könnte und woran die Forschung derzeit arbeitet.